ちょっと準備

正規分布の平均 と分散

に関する計算をする際に、

(つまり、

)とおいて、

の代わりに

で計算することがあります。この方が計算が簡単になることが多いためですが、一般に、分散

の逆数を精度(precision)

と呼びます。精度が大きい(精度が高い)というのは、分散が小さくて確率分布が平均のまわりによく尖っていることになります。

これ以降の議論でも、言葉では「分散」と言いますが、数式上は精度 を用いて表します。

ベイズ推定による正規分布の決定

下記の記事では、ベイズ推定の一般的な考え方を紹介しました。ベイズ推定は、ある事柄の確率を観測データを元に洗練していく(「確信度」を高めていく)手法とも言えるでしょう。

一方、次の記事の後半にある「単純化した例で数値計算」では、未知の正規分布の「平均」と「分散」を観測データ(トレーニングセット)を元に「最尤推定」でフィッティングする方法を紹介しました。

しかしながら、記事の中で触れたように「最尤推定」以外の推定方法が存在しないわけではありません。ここでは、ベイズ推定のテクニックを用いてフィッティングしてみます。

ただし、少しだけ計算を簡単にするために分散は予め (特定の定数)とわかっているとして、平均

が未知の正規分布について、観測データ(トレーニングセット)を元に「平均の値」をフィッティングします。

―― と言って、何をするのか想像できるでしょうか? 実は、ものすごい(ある意味適当な)ことをやります。

ベイズ推定は、『「観測データ」を元に「ある事柄の確率」を洗練していく』と説明しました。今の場合、「観測データ」に相当するのは「未知の正規分布から得られたトレーニングセット」です。一方、「ある事柄」に相当するのは・・・、そう、「平均 の値」です。つまり、ここでは、平均

がある値をとる確率

が存在するとして、これをベイズの定理から計算していきます。

ここで言う確率は、「確信度」の意味で考えるとよいでしょう。つまり、 はいろいろな値の可能性があって、値ごとに「これが正しいかも?」という確信度

が決まっていると思ってください。

それでは、何の前提条件(観測データ)も無い時、どのような確信(事前分布)を持つべきでしょうか? 特に根拠はないのですが、ここでは仮に を適当な定数として、

と仮定します。これは、 の確率が最も高くなる正規分布です。

何の前提もあらへんのに の確率が高いってなんで分かるんや?

というツッコミは無視します。

―― というのは嘘で、 (分散が無限大)の極限をとると、これは、あらゆる

について確率が一定のフラットな分布になります。ここでは、仮にこのような分布を想定しておいて、最後にこの極限でどうなるかを観察することにします。

ちなみに、前提条件が無い時の分布を「事前分布」と呼びますが、事前分布をどのようにとるかは、フィッティング条件を決める人が恣意的に選択することがよくあります。繰り返しになりますが、ここでやっているのは、「いろいろあるフィッティング条件の中の一例」を作っているにすぎません。そのような事前分布でフィッティングすれば、有用な結果(つまり、未知のデータをよりよく推定する関数)が得られるかは、試行錯誤を必要とする非常に難しい問題なのです。

それでは、未知の正規分布から、観測データ群(トレーニングセット) が得られたとします。このデータを前提条件とすると、先ほどの確率はどのように変化するでしょうか? ベイズの定理を用いると次のように計算できます。

(※分母の は本当は積分ですが、簡単のためにこのように記載しています。)

ここで、右辺分子の は、未知の正規分布の平均が特定の値

を取る場合に、

が得られる確率ですので、次の通りです。

また、分母の は、

には依存しない値ですので、最終的に、観測データ取得後の

の確率(確信度)として次の関係式が成り立ちます。(

に依存する比例項だけを取り出しています。)

―― (1)

したがって、(1)の値を最大にする の値を見つければ、それが最も確率の高い(確信度が高い)値

ということになります。

なお、(1)をよく見ると の中は

についての二次関数であり、(1)は

についての正規分布になっていることが分かります。

について平方完成すると、次の結果が得られます。

ここに、

この結果から重要な性質が読み取れます。

まず、最も確率の高い(確信度の高い)値 に着目すると、

の極限では、最尤推定と同じで、

となります。一方、

の場合、

とは、最尤推定よりも

の方に寄った値になります。(

は、

と

を

の比に分割する値ですね。)

つまり、「 に近いほうが確率が高い」という事前分布(前提条件がない状態での確信度)に影響されて、前提条件をつけた後も

に寄った答えとなるわけです。

ただし、十分な数の観測を行えば、事前分布の影響はなくなります。つまり、 の極限で

となります。先ほど「事前分布のとり方は恣意的」と言いましたが、一般に十分な観測が行える環境下では、最終結果は事前分布に依存しないと期待することができます。大量のトレーニングセット(ビッグデータ?)があれば、前提が多少いい加減でも、それなりによい結果が得られると期待できるわけです。

ベイズ推定ならではの考え方

ここまでの結果を見ると「ベイズ推定も結局は最尤推定と同じじゃん」と言いたくなりますが、実は、重大な違いがあります。最尤推定で得られるのは、あくまでも、 に対する特定の推定値

だけです。一方、ベイズ推定の場合は、「最も確率(確信度)の高い値」としては最尤推定と同じですが(

、もしくは、

の極限の場合)、それ以外の値についてもそれぞれの確率(確信度)が与えられました。

―― (2)

つまり、ベイズ推定の立場では、最も確率の高い値だけを特別扱いするのではなく、あらゆる値について、その確率に応じた割合で、その可能性を認めるべきなのです。(2)は分散 の正規分布ですので、

にはこの分散程度の不確定性が残っています。

この式を見ると、 の極限では、分散は0になります。つまり、観測を行う前の

の状態では、事前分布に従って

の不確定性がありますが、観測を積み重ねるに従って分散(不確定性)は減っていき、最終的には不確定性がなくなります。つまり、ベイズ推定の結論は、最尤推定と厳密に一致します。

しかしながら、 が有限の場合は、仮に

の極限でも分散は残るので、この影響を無視するわけには行きません。

たとえば、あるトレーニングセット が得られた場合、この「未知の正規分布」から次にある値

が観測される確率は、あらゆる

における確率(2)の「期待値」として計算します。

つまり、次の結果が得られました。

もともと未知の正規分布の分散は と分かっていたにも関わらず、次の

はそれよりも

だけ大きな分散で推定しています。これは、観測データが少ないために、

が真の平均

と同じである自信がない事に対応します。

に含まれる誤差(分散

)を考慮して、その分だけ大きな分散で次の

を予測しているというわけです。

実際、観測データを増やしていくと(つまり、 を大きくしていくと)、

が大きくなっていくので、

の極限では、

となります。つまり、 が真の平均

と同じであると自信を持って言えるので、もともとわかっている分散

で予測ができるわけです。

数値計算で確認

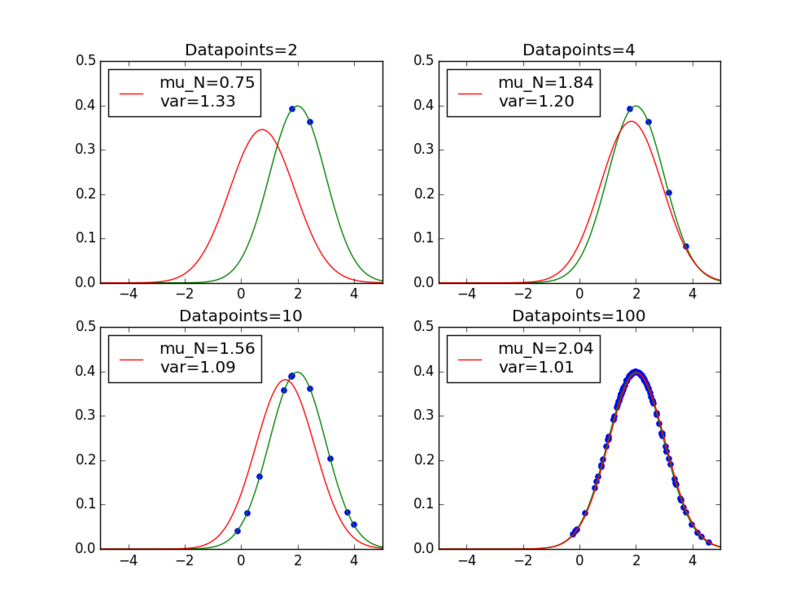

実際に数値計算した結果をグラフにして見てみます。

これから推定する「未知の正規分布」として、平均2, 分散1の正規分布を用意して、ここから100個のサンプルを取り出します。100個のサンプルから先頭の 2, 4, 10, 100個をトレーニングセットとして用いて、平均 に対するBayes推定を行います。平均

の事前分布は、平均-2, 分散1とします。

まず、次式で表される「 の事後分布」をグラフにするコードです。

import numpy as np import matplotlib.pyplot as plt import pandas as pd from pandas import Series, DataFrame from numpy.random import normal from scipy.stats import norm if __name__ == '__main__': mu_true = 2.0 beta_true = 1.0 mu_0 = -2.0 beta_0 = 1.0 fig = plt.figure() ax = {} ds = normal(loc=mu_true, scale=1.0/beta_true, size=100) for c, n in enumerate([2,4,10,100]): trainset = ds[0:n] mu_ML = np.mean(trainset) mu_N = (beta_true*mu_ML + beta_0*mu_0/n)/(beta_true+beta_0/n) beta_N = beta_0 + n*beta_true # Show fitting curves ax[c] = fig.add_subplot(2,2,c+1) ax[c].set_title("Datapoints=%d" % n) linex = np.arange(-10,10.1,0.1) # distribution of estimated mu sigma = 1.0/beta_N mu_est = norm(loc=mu_N, scale=np.sqrt(sigma)) label = "mu_N=%.2f\nvar=%.2f" % (mu_N, sigma) ax[c].plot(linex, mu_est.pdf(linex), color='red', label=label) ax[c].legend(loc=2) # data points of the training set ax[c].scatter(trainset, [0.2]*n, marker='o', color='blue') ax[c].set_xlim(-5,5) ax[c].set_ylim(0) fig.show()

実行結果は次のようになります。

このグラフは、元の正規分布を示しているのではなく、平均 の確率を示している点に注意してください。使用するデータを増やすにつれて、グラフの中心

が、事前分布の中心

から、正しい平均

に変化していることが分かります。また、その中心の値が正しいという「確信度」が上がって、グラフの広がり(分散)が狭まっていきます。

続いて、次に取得されるデータの推定を示す下記のグラフを描きます。これは、「未知の正規分布」に一致するべきものになります。

import numpy as np import matplotlib.pyplot as plt import pandas as pd from pandas import Series, DataFrame from numpy.random import normal from scipy.stats import norm if __name__ == '__main__': mu_true = 2.0 beta_true = 1.0 mu_0 = -2.0 beta_0 = 1.0 fig = plt.figure() ax = {} ds = normal(loc=mu_true, scale=1.0/beta_true, size=1000) for c, n in enumerate([2,4,10,100]): trainset = ds[0:n] mu_ML = np.mean(trainset) mu_N = (beta_true*mu_ML + beta_0*mu_0/n)/(beta_true+beta_0/n) beta_N = beta_0 + n*beta_true ax[c] = fig.add_subplot(2,2,c+1) ax[c].set_title("Datapoints=%d" % n) linex = np.arange(-10,10.1,0.1) # Correct distribution orig = norm(loc=mu_true, scale=np.sqrt(1.0/beta_true)) ax[c].plot(linex, orig.pdf(linex), color='green') # Estimated distribution sigma = 1.0/beta_true+1.0/beta_N mu_est = norm(loc=mu_N, scale=np.sqrt(sigma)) label = "mu_N=%.2f\nvar=%.2f" % (mu_N, sigma) ax[c].plot(linex, mu_est.pdf(linex), color='red', label=label) ax[c].legend(loc=2) # Datapoints of the training set ax[c].scatter(trainset, orig.pdf(trainset), marker='o', color='blue') ax[c].set_xlim(-5,5) ax[c].set_ylim(0) fig.show()

実行結果は次のようになります。緑のカーブが「未知の正規分布」で、赤のカーブが「ベイズ推定で得られた分布」です。